בעוד התוכנית השנויה במחלוקת של אפל לצוד חומר של התעללות מינית בילדים באמצעות סריקה באייפון נזנחה, לחברה יש תוכניות אחרות בראש לעצור זאת במקור.

הודיעה אפלשתי יוזמותבסוף 2021 שמטרתה להגן על ילדים מפני התעללות. אחד, שכבר בתוקף היום,היה מזהירקטינים לפני שליחת או קבלה של תמונות עם תוכן עירום. זה עובד באמצעות זיהוי אלגוריתמי של עירום ורק מזהיר את הילדים - ההורים לא מקבלים הודעה.

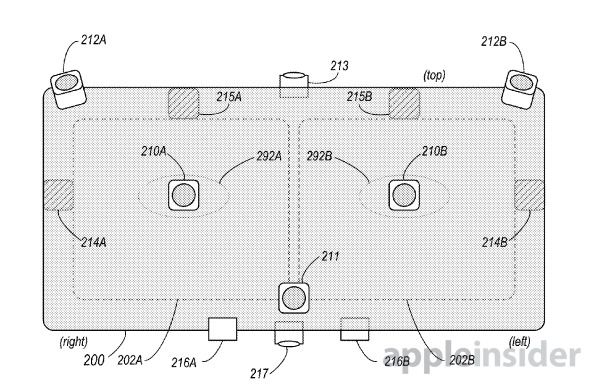

התכונה השנייה, והשנויה הרבה יותר במחלוקת, תנתח תמונות של משתמש שהועלו ל-iCloud באייפון של המשתמש עבור תוכן CSAM ידוע. הניתוח בוצע באופן מקומי, במכשיר, באמצעות מערכת hashing.

לאחר תגובה נגדית ממומחי פרטיות,קבוצות בטיחות ילדים, וממשלות, אפלהשהה את התכונהלבדיקה ללא הגבלת זמן. ביום רביעי, אפל פרסמה הצהרה לAppleInsiderומקומות אחרים שמסבירים שהיא נטשה את התכונה לחלוטין.

"לאחר התייעצות מקיפה עם מומחים לאיסוף משוב על יוזמות להגנה על ילדים שהצענו בשנה שעברה, אנו מעמיקים את ההשקעה שלנו בתכונת בטיחות התקשורת שהפכנו לראשונה בדצמבר 2021.""החלטנו עוד לא להתקדם עם כלי זיהוי ה-CSAM שהוצע בעבר עבור תמונות iCloud. ניתן להגן על ילדים מבלי שחברות יסרוקו נתונים אישיים, ואנו נמשיך לעבוד עם ממשלות, תומכי ילדים וחברות אחרות כדי לסייע בהגנה על צעירים , לשמור על זכותם לפרטיות ולהפוך את האינטרנט למקום בטוח יותר לילדים ולכולנו".

ההצהרה מגיעה רגע אחריהודיעה אפלתכונות חדשות שיצפנו מקצה לקצה אפילו יותר נתוני iCloud, כוללiMessageתוכן ותמונות. הגנות מחוזקות אלו היו הופכות את מערכת הדגל בצד השרת לבלתי אפשרית, שהייתה חלק עיקרי מתכונת זיהוי ה-CSAM של אפל.

נוקט בגישה אחרת

אמזון, גוגל, מיקרוסופט ואחרות מבצעות סריקה בצד השרת כדרישה על פי חוק, אך הצפנה מקצה לקצה תמנע מאפל לעשות זאת.

במקום זאת, אפל מקווה לטפל בבעיה במקור שלה - יצירה והפצה. במקום לכוון לאלה שאוגרים תוכן בשרתי ענן, אפל מקווה לחנך את המשתמשים ולמנוע מלכתחילה את יצירת התוכן והשליחה.

אפל סיפקהפרטים נוספיםעל יוזמה זו לחוטי. אמנם אין ציר זמן לתכונות, אבל זה יתחיל בהרחבת זיהוי העירום האלגוריתמי לווידאו עבור תכונת בטיחות התקשורת. לאחר מכן, אפל מתכננת להרחיב את ההגנות הללו לכלי התקשורת האחרים שלה, ולאחר מכן לספק למפתחים גישה גם כן.

"ניתן להפריע לניצול פוטנציאלי של ילדים לפני שהוא קורה על ידי מתן כלים להורים כדי לעזור להגן על ילדיהם מפני תקשורת לא בטוחה", אמרה אפל גם בהצהרה. "אפל מחויבת לפיתוח פתרונות חדשניים לשמירה על הפרטיות כדי להילחם בחומרי התעללות מינית בילדים ולהגן על ילדים, תוך מענה לצרכי הפרטיות הייחודיים של תקשורת אישית ואחסון נתונים."

הגנות אחרות במכשיר קיימות ב-Siri, Safari ו-Spotlight כדי לזהות מתי משתמשים מחפשים CSAM. זה מפנה את החיפוש למשאבים המספקים עזרה לאדם.

תכונות המחנכות משתמשים תוך שמירה על הפרטיות היו המטרה של אפל במשך עשרות שנים. כל ההטמעות הקיימות לבטיחות ילדים מבקשות ליידע, ואפל אף פעם לא לומדת מתי תכונת הבטיחות מופעלת.